hadoop生态系统,构建大数据处理平台的关键组件

时间:2024-11-06 来源:网络 人气:

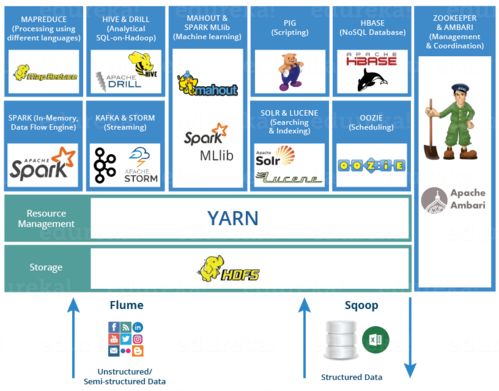

深入解析Hadoop生态系统:构建大数据处理平台的关键组件

随着大数据时代的到来,如何高效处理和存储海量数据成为企业面临的重大挑战。Hadoop生态系统作为一种强大的解决方案,为大数据处理提供了坚实的基础。本文将深入解析Hadoop生态系统的关键组件,帮助读者全面了解这一大数据处理平台。

一、Hadoop简介

Hadoop是由Apache基金会开发的开源分布式计算框架,主要用于处理大规模数据集。它由多个组件构成,共同协作以实现高效的数据存储、处理和分析。

二、Hadoop核心组件

1. HDFS(Hadoop分布式文件系统)

HDFS是Hadoop的核心存储系统,它将数据分割成大块,并存储在集群中的多个节点上。这种设计确保了数据的可靠性和容错性,同时提高了数据访问速度。

2. MapReduce

MapReduce是Hadoop的核心计算模型,它将数据处理任务分解为Map和Reduce两个阶段。Map阶段将输入数据转换为键值对,Reduce阶段则将键值对合并为最终结果。这种模型适用于并行处理大规模数据集。

3. YARN(Yet Another Resource Negotiator)

YARN是Hadoop的资源管理和调度平台,它负责为运算程序提供服务器资源。YARN通过优化资源分配,提高了Hadoop集群的效率。

三、Hadoop生态系统中的其他重要组件

1. Hive

Hive是一个基于Hadoop的数据仓库工具,它允许用户使用类似SQL的查询语言(HiveQL)来查询存储在HDFS中的数据。Hive简化了大数据处理流程,降低了用户的学习成本。

2. Pig

Pig是一个高级数据流语言,用于简化Hadoop中的数据处理任务。Pig Latin是Pig的脚本语言,它允许用户编写复杂的数据处理逻辑,并将其转换为MapReduce作业。

3. HBase

HBase是一个分布式、可扩展的NoSQL数据库,它基于HDFS构建。HBase适用于存储非结构化或半结构化数据,并提供了实时读写能力。

4. ZooKeeper

ZooKeeper是一个分布式协调服务,它为分布式应用提供一致性服务。ZooKeeper在Hadoop生态系统中扮演着重要的角色,例如,它用于管理HBase的集群状态。

5. Sqoop

Sqoop是一个数据迁移工具,它可以将数据在Hadoop和传统数据库之间进行迁移。Sqoop简化了数据迁移过程,提高了数据处理的效率。

四、Hadoop生态系统的优势

1. 高可靠性

Hadoop生态系统通过数据冗余和故障转移机制,确保了数据的可靠性和容错性。

2. 高扩展性

Hadoop生态系统可以轻松扩展,以适应不断增长的数据量。

3. 高效性

Hadoop生态系统通过并行处理和优化资源分配,提高了数据处理效率。

4. 低成本

Hadoop生态系统可以在廉价的硬件上运行,降低了企业的成本。

Hadoop生态系统为大数据处理提供了强大的支持,其丰富的组件和工具使得企业能够高效地处理和存储海量数据。随着大数据时代的不断发展,Hadoop生态系统将继续发挥重要作用,为企业创造更多价值。

相关推荐

教程资讯

教程资讯排行