hdfs 文件系统,什么是HDFS?

时间:2024-10-17 来源:网络 人气:

深入解析HDFS:Hadoop分布式文件系统的工作原理与应用

什么是HDFS?

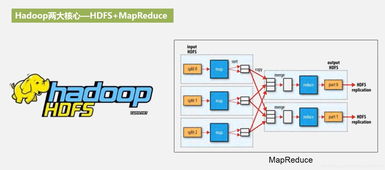

HDFS(Hadoop Distributed File System,Hadoop分布式文件系统)是Apache Hadoop项目的一个核心组件,它是一个专为大规模数据存储而设计的分布式文件系统。HDFS的设计目标是支持高吞吐量的数据访问,适合存储海量数据,并且能够在普通服务器上运行,以实现低成本的大数据存储解决方案。

HDFS的设计理念

HDFS的设计理念基于以下几个核心原则:

- 高容错性:通过数据冗余和自动恢复机制,确保数据在硬件故障的情况下不会丢失。

- 高效性:通过并行化处理和优化数据访问模式,提高数据读写效率。

- 流式数据访问:支持一次写入、多次读取的数据访问模式,适合大数据分析场景。

- 移动计算:在处理大数据时,将计算任务移动到数据所在的节点上执行,以减少数据传输的开销。

- 简单的文件模型:提供类似本地文件系统的文件操作接口,易于使用。

- 跨平台兼容性:可以在不同的硬件和操作系统上运行,具有良好的可移植性。

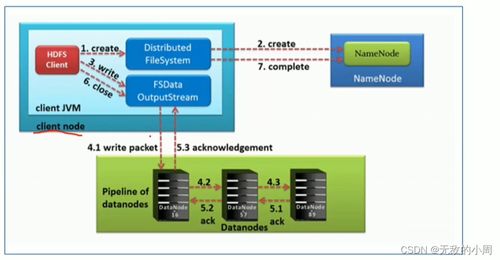

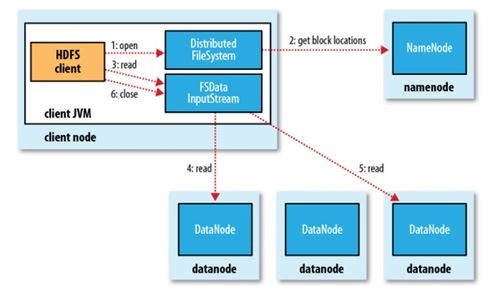

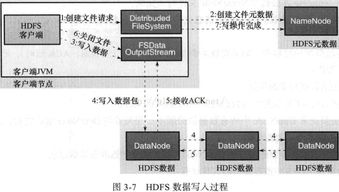

HDFS的工作原理

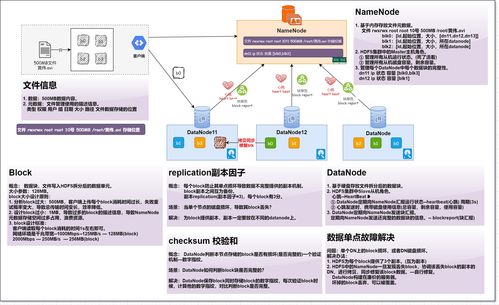

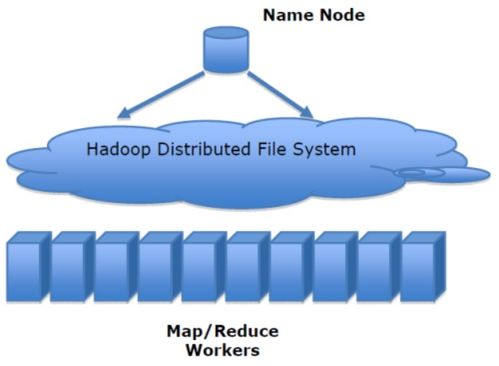

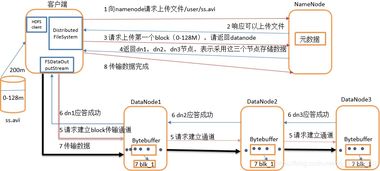

HDFS将大文件分割成多个数据块(默认为128MB),这些数据块被分布存储在集群中的多个节点上。HDFS的主要组件包括:

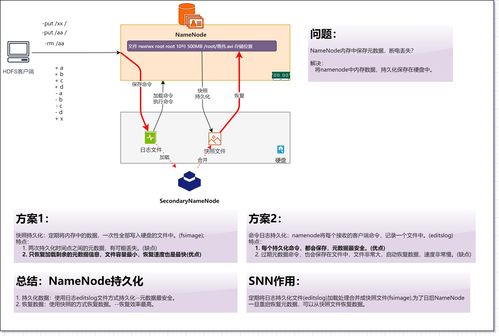

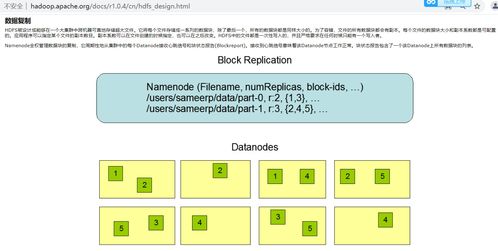

- NameNode:负责管理文件系统的命名空间,维护文件系统的元数据,如文件名、目录结构、文件块的映射信息等。

- DataNode:负责存储实际的数据块,并响应来自NameNode的读写请求。

- Secondary NameNode:定期从NameNode复制元数据,以减轻NameNode的负载,并辅助NameNode进行元数据的备份。

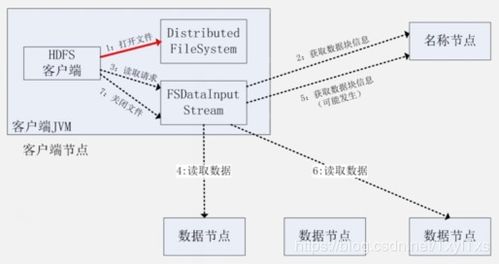

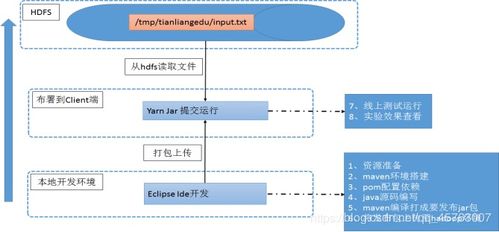

当用户访问HDFS时,客户端首先通过NameNode获取文件块的存储位置,然后直接与存储数据块的DataNode进行通信,完成数据的读写操作。

HDFS的优势与局限性

优势:

- 高容错性:通过数据冗余和自动恢复机制,即使部分节点故障,数据也不会丢失。

- 高吞吐量:适合处理大规模数据集,提供高吞吐量的数据访问。

- 可扩展性:可以轻松地通过增加节点来扩展存储容量。

- 低成本:可以在普通服务器上运行,降低大数据存储的成本。

局限性:

- 低延时数据访问受限:由于数据块分布在不同的节点上,访问数据可能存在一定的延迟。

- 不适合小文件存储:HDFS为每个文件块分配固定大小的存储空间,对于小文件来说,存储效率较低。

- 不适合并发写入:HDFS不支持并发写入同一个文件,可能会影响性能。

- 不支持修改文件:HDFS不支持对文件的修改,只能通过删除旧文件并创建新文件的方式来更新数据。

HDFS的应用场景

尽管HDFS存在一些局限性,但它仍然在许多大数据应用场景中发挥着重要作用,例如:

- 大数据分析:HDFS是Hadoop生态系统中的核心组件,广泛用于大数据分析。

- 日志存储:许多企业使用HDFS来存储和分析日志数据。

- 数据仓库:HDFS可以作为数据仓库的基础,存储和管理大量数据。

- 科学计算:HDFS在科学计算领域也有广泛应用,如基因组学、气象学等。

HDFS作为Hadoop生态系统中的核心组件,为大数据存储提供了高效、可靠、可扩展的解决方案。尽管存在一些局限性,但HDFS在许多大数据应用场景中仍然具有不可替代的地位。随着技术的不断发展,HDFS将继续优化和改进,以满足不断增长的大数据存储需求。

相关推荐

教程资讯

教程资讯排行