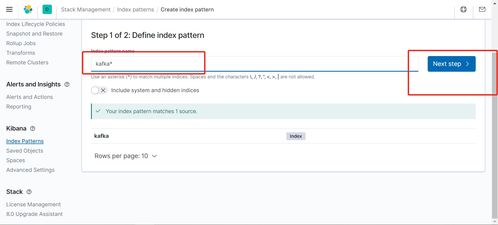

kafka 日志系统,高效、可靠的分布式日志解决方案

时间:2024-09-27 来源:网络 人气:

Kafka日志系统:高效、可靠的分布式日志解决方案

随着大数据时代的到来,日志数据量呈爆炸式增长,如何高效、可靠地处理这些日志数据成为企业关注的焦点。Kafka作为一种高性能的分布式消息队列系统,在日志系统中扮演着重要角色。本文将详细介绍Kafka日志系统的特点、架构以及应用场景。

一、Kafka日志系统的特点

1. 高吞吐量:Kafka能够处理大量的日志数据,支持高并发的写入和读取操作,满足大规模日志系统的需求。

2. 可靠性:Kafka采用分布式架构,具有高可用性和容错性,即使部分节点故障,也不会影响整个系统的正常运行。

3. 可扩展性:Kafka支持水平扩展,通过增加Broker节点来提高系统处理能力,满足不断增长的日志数据量。

4. 持久性:Kafka将日志数据持久化存储在磁盘上,确保数据不会因系统故障而丢失。

5. 易于集成:Kafka提供丰富的客户端库,方便与其他系统进行集成,如日志收集器、监控系统等。

二、Kafka日志系统架构

1. 生产者(Producer):负责将日志数据发送到Kafka集群。生产者可以是应用程序、日志收集器或其他系统。

2. 消费者(Consumer):从Kafka集群中读取日志数据。消费者可以是应用程序、监控系统或其他系统。

3. 主题(Topic):Kafka中的日志数据按照主题进行分类。每个主题可以包含多个分区(Partition),分区是Kafka存储日志数据的基本单位。

4. 分区(Partition):Kafka将日志数据分散存储在多个分区中,提高系统处理能力和并发性。

5. Broker:Kafka集群中的节点称为Broker,负责存储和管理日志数据。每个Broker可以存储多个主题的分区。

6. Zookeeper:Kafka集群使用Zookeeper来维护集群元数据,如主题、分区、Broker信息等。

三、Kafka日志系统应用场景

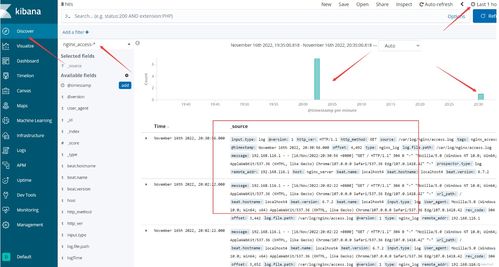

1. 日志收集:Kafka可以与各种日志收集器(如Fluentd、Logstash等)集成,实现大规模日志数据的收集和传输。

2. 监控系统:Kafka可以作为监控系统的基础设施,将系统日志、性能指标等数据传输到Kafka集群,供监控系统进行分析和处理。

3. 数据分析:Kafka可以与大数据处理框架(如Hadoop、Spark等)集成,实现大规模日志数据的实时分析和处理。

4. 容灾备份:Kafka支持跨地域部署,可以实现日志数据的容灾备份,确保数据安全。

Kafka日志系统凭借其高效、可靠、可扩展等特点,成为分布式日志处理的首选方案。随着大数据时代的到来,Kafka日志系统在各个领域得到广泛应用,为企业提供了强大的日志处理能力。

相关推荐

教程资讯

教程资讯排行